Пользователи в сети сходят с ума по интерактивному инструменту GPT-3. Его теоретические возможности и пути использования поразительны и невероятно многогранны. (G)enerative (P)retrained (M)odel 3 это третье поколение алгоритма обработки естественного языка от OpenAI. Он станет вашим настоящим другом и помощником, поскольку будет вести себя именно так, как вы ему скажете.

Если вы хотите заглянуть в будущее, взгляните на то, как разработчики уже используют GPT-3. Без сомнения, следует сказать, в нашем мире полно примеров использования ИИ: начиная от спецпредложений для покупки на Amazon и заканчивая беспилотными автомобилями. ИИ везде успел приложить свою руку. Более того, есть большая вероятность, что именно ИИ сподвигнул вас прочитать данную статью, а другие технологии были задействованы для ее написания.

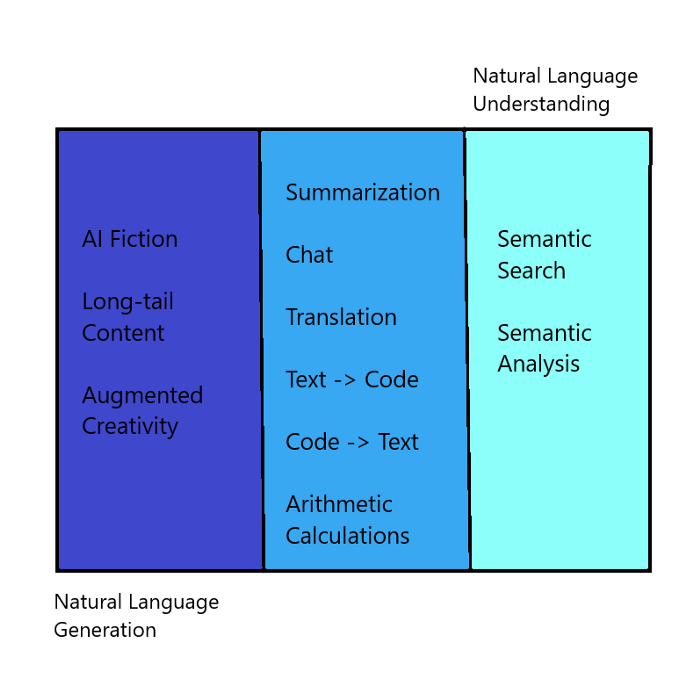

GPT-3 это специальный алгоритм, который может выполнять различные задачи по обработке человеческой речи. Он может выступать в роли писателя, журналиста, поэта, автора, исследователя или бота. GPT-3 также рассматривается исследователями как алгоритм, с помощью которого мы сможем сделать первый шаг к созданию Artificial General Intelligence (AGI). AGI это способность машин учиться и выполнять задачи, подобные тем, которые решают люди.

Было время, когда данный алгоритм был настоящей загадкой для ученых. Однако по мере развития технологий он становился все более доступным как специалистам, так и обычным пользователям. Чтобы понять основы того, как работает GPT-3, мы должны ознакомиться с принципами машинного обучения, которое является ключевым моментом в работе этого уникального алгоритма. Машинное обучение это неотъемлемая часть искусственного интеллекта. Оно позволяет машине улучшать себя с помощью полученного опыта.

Существует два типа алгоритмов машинного обучения: контролируемые и неконтролируемые.

Контролируемое обучение включает в себя алгоритмы, которые нуждаются в маркированных данных. Другими словами, предположим, что ваша машина это 5-летний ребенок. Вы хотите научить ее читать, а затем проверить, был ли получен данный навык. При контролируемом обучении мы предоставляем машине маркированные данные. После этого мы проверяем, смогла ли она научиться чему-то или нет.

Люди, конечно, приобретают навыки и во время контролируемого обучения. Однако большую часть своего времени они учатся, анализируя свой опыт и пытаясь предугадать будущее с помощью интуиции. Именно в этом и состоят принципы неконтролируемого обучения.

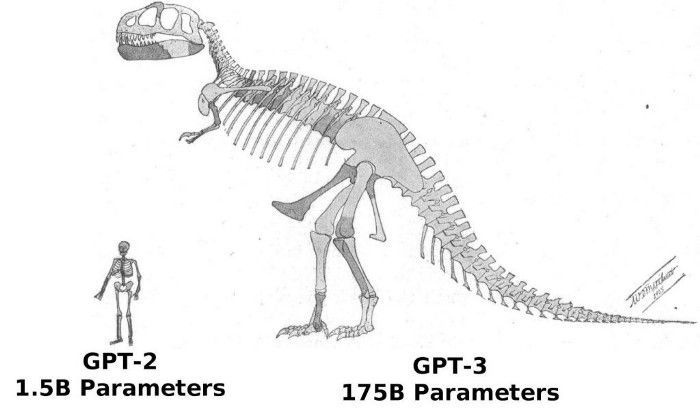

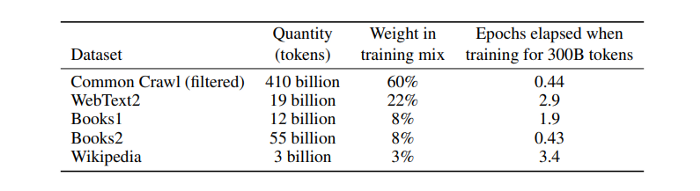

GPT-3 использует неконтролируемое обучение. Он способен к мета-обучению, то есть обучению без какой-либо подготовки. Учебный корпус GPT-3 состоит из набора данных типа common-crawl. Он включает в себя 45 ТБ текстовых данных, полученных из Интернета. GPT-3 имеет 175 миллиардов параметров моделей, в то время как человеческий мозг обладает 10-100 триллионами.

Чтобы понять принципы жизнеустройства на Земле, масштабы Вселенной и другие человеческие тонкости необходимо иметь 4,398 триллиона параметров моделей. То, с каким темпом растет этот показатель у GPT, пугает каждый год он увеличивается примерно в 100 раз, что одновременно удивительно и вызывает беспокойство.

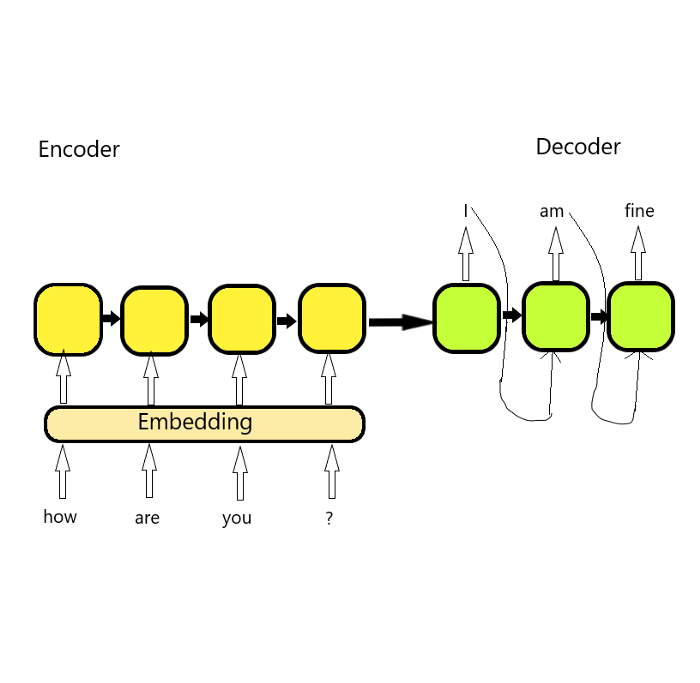

Мы знаем, что модели машинного обучения всегда работают с высокой точностью. Однако анализ человеческого языка это их слабое место. Чтобы справиться с этим недостатком, мы преобразуем текст в числа с помощью встраивания и передаем их нашим машинам. В машинах используются кодеры и декодеры, которые помогают им распознать сообщение.

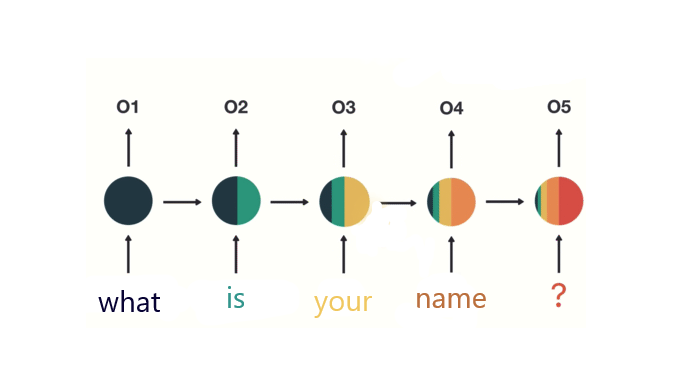

Рекуррентные нейронные сети (РНС) это класс нейронных сетей, которые хороши для моделирования последовательных данных, таких как временные ряды или естественный язык. Однако из-за огромного объема текстовой информации мы не можем быть уверены в том, что сообщение будет прочитано доскональным образом. Для лучшего распознавания отправленного месседжа мы используем механизм внимания. Он работает точно так же, как и наш мозг. Когда мы сохраняем определенную информацию в нем, он отфильтровывает важные данные и удаляет ненужные. Механизм внимания помогает вести счет каждому вложению. Оценка важности данных дает возможность отфильтровывать нерелевантную информацию.

Когда мы отправляем наши текстовые данные машине, они проходят через кодер, после чего создаются векторы. Полученные векторы далее анализируются механизмом внимания. Такой смешанный процесс помогает предсказать следующее слово, которое скажет человек. Проще говоря, происходит «заполнение пробелов», основанное на том, насколько машина уверена в своих знаниях. По мере того, как она овладевает языком, машина может лучше предугадывать следующие слова. Имея огромный опыт, она будет с точностью прогнозировать возможные варианты. Далее, мы отправляем полученное слово с имеющимся предсказанием в декодер. Цикл генерирования новых предложений продолжается бесконечно, что помогает улучшать AGI.

Главной изюминкой GPT-3 является его огромный корпус данных и бесконечные возможности обучения. Само обучение не является предметно-специфичным, но позволяет алгоритму научиться выполнять любую предметно-специфичную задачу. Попросите алгоритм написать SQL-запрос, и он справится. Попросите его помочь в сочинении текста на спортивную тематику он также сможет это сделать.

GPT-3 работает лучше с несколькими кадрами обучения: когда вы предоставляете ему подсказку и несколько примеров. Представьте, что вы дали пару книг первокурснице и попросили ее ответить на вопросы. Иногда ей это удавалось, а иногда она не справлялась. Поэтому вы продолжаете давать ей все больше книг и задавать все больше вопросов, что помогает ей совершенствовать свои знания. Она делает это, знакомясь с новым материалом и просматривая примеры похожих вопросов.

GPT-3 это все-таки машина, она сможет учиться, беря за основу множество примеров. Когда мы учимся водить автомобиль, мы выбираем огромное количество мест, чтобы отточить свой навык. Мы начинаем с дорог, по которым ездит небольшое количество машин. Затем мы отправляемся на трассы с более плотным автомобильным движением. И, наконец, обретя полную уверенность в себе, мы едем по самой оживленной улице, чтобы приобрести необходимый нам навык. Если вы будете ездить по дорогам только со средней загруженностью, то вы точно не сможете водить машину в час-пик. Точно так же, если мы хотим получить лучшую модель, нам нужно предоставить ей различные условия для обучения.

GPT-3 учится постоянно. Он является лучшим алгоритмом в сфере ИИ. Однако GPT-3 не может вести себя точно так же, как мы. В конце концов, детям не нужно видеть миллионы примеров, чтобы узнать что-то новое. GPT-3 учится в Интернете и иногда поглощает весь негатив, который находится там. Он может имитировать естественный язык, но когда дело доходит до естественных мыслей, ИИ все еще терпит неудачу. Существует тонкая грань между естественным языком и естественными мыслями. GPT-3 доказал, что масштабирование языковой модели может повысить точность высказываний. Чтобы использовать язык, идентичный человеческому, машине нужна не душа, а огромное количество данных.

Когда я был ребенком, наш учитель давал нам первую часть сценария и просил написать продолжение. Я часами придумывал повороты сюжета и после приносил их своему преподавателю. Каждый раз я получал низкие оценки и не понимал за что.

В течение многих лет я продолжал это делать и все также не понимал причину. Однако однажды до меня дошло, что я делаю все неправильно. Я был слишком занят, сосредоточившись на своих творческих мыслях, но все, что было нужно, чтобы получить хорошую оценку, - это отсутствие грамматических ошибок. Видимо, он учил нас «писать», а не «творчески мыслить». Хочется все-таки признаться в том, что грамматика не была моей сильной стороной, в отличие от создания нтересного сюжета.

Это именно то, что делает GPT-3. Он черпает большую часть своих знаний из предыдущих работ, созданных людьми. И все, о чем он переживает, - это создание подобным человеческим мыслей и слов. Он фокусируется на «стиле», а не на «творчестве или понимании причин». Грамматика это его язык программирования.

Нельзя отрицать, что он хорошо предсказывает возможные варианты слов. Однако GPT-3 не предназначен ни для хранения фактов, ни для их извлечения в нужное время, как это делает человеческий мозг. Он больше похож на алгоритм для подбора ключевых слов по шаблону, как в случае с SEO.

Подобной машине (даже после знакомства с людьми посредством Интернета) не хватает человеческих черт. Это всего лишь алгоритм, и неразумно ждать, что он сможет «высказать» свои личные мысли. Ему все еще не хватает IQ, который и отличает людей от машин. Я надеюсь, что так будет и дальше (хотя бы какое-то время).